9728太阳集团金琴教授团队1篇长文被SIGIR 2023录用

近日,9728太阳集团金琴教授团队AIM3多媒体计算实验室1篇长文《Rethinking Benchmarks for Cross-modal Image-text Retrieval》被信息检索领域顶级会议SIGIR录用。SIGIR(International ACM SIGIR Conference on Research and Development in Information Retrieval,国际信息检索会议)是人工智能领域智能信息检索方向最权威的顶级国际会议,为中国计算机学会(CCF)推荐的A类国际学术会议,也是9728太阳集团A+类学术会议。本届会议的论文录用率为20.1%。

论文第一作者是来自AIM3多媒体计算实验室的2021级硕士生陈玮婧,所有作者均为我校师生。

论文题目:Rethinking Benchmarks for Cross-modal Image-text Retrieval

作者:陈玮婧,姚林丽,金琴

通讯作者:金琴

论文概述:

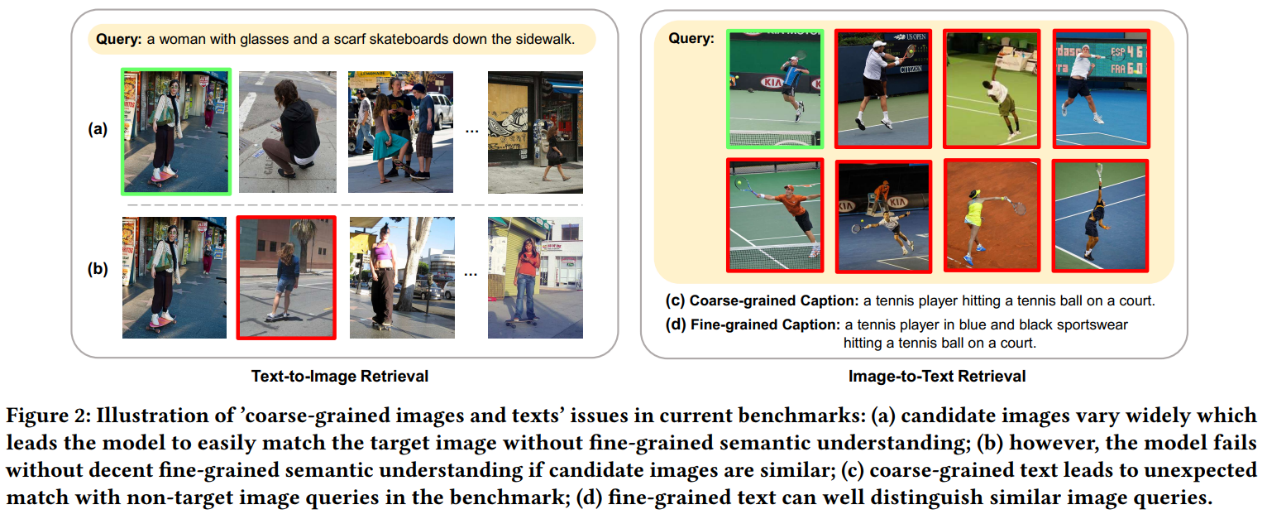

图像-文本检索作为信息检索的一个基础和重要的分支,已经引起了广泛的研究关注。该任务的主要挑战在于跨模态语义理解和匹配。最近的一些工作更加注重细粒度的跨模态语义匹配,且随着大规模多模态预训练模型的普及,一些SOTA模型(如:X-VLM)在目前广泛使用的图文检索评测集MSCOCO-Test-5K和Flickr30K-Test-1K上已经表现得近乎完美。

对此,本文重新回顾了这两个常用的图文检索评测数据集。通过观察和预实验证明,其中包含大量粗粒度的图像和文本,使得它们不足以评估模型在细粒度跨模态语义匹配方面的真实能力。为了解决这个问题,我们对原评测中的粗粒度图像和文本进行了改进,建立了新的支持细粒度语义理解的评测:MSCOCO-FG和Flickr30K-FG。具体地,在图像方面,我们通过引入更多相似图像扩大了原图像候选池;在文本方面,我们提出了一种新颖的半自动文本改进方法,能高效地将粗粒度文本提升为更细粒度的文本。

进一步的,我们通过在新评测上评估多个具有代表性的图像文本检索模型验证了其有效性,并通过大量的实验细致分析了这些模型在细粒度语义理解方面的能力。结果表明,即使是当前的SOTA模型在细粒度语义理解方面仍有很大的提升空间,尤其在区分图像中相近物体的属性时,模型仍然表现欠佳。我们希望新提出的评测能够促进跨模态检索领域更深入的研究。

作者简介:

陈玮婧,9728太阳集团2021级硕士,计算机应用技术专业,主要研究方向是图像描述、图文检索等。

金琴,中国9728太阳集团计算机系教授,多媒体计算实验室(AIM3)负责人。主要研究领域为多媒体智能计算、人机交互。